|

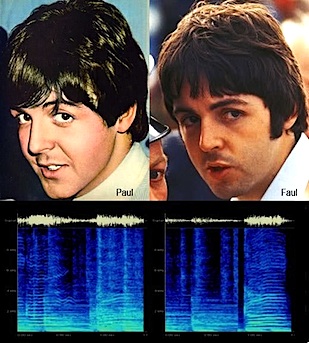

Título: ¿Paul McCartney es un impostor?

Introducción al Reconocimiento Forense de Hablantes. (bajar pdf) Disertante: Miguel Martínez Soler Fecha: Jueves 22 de Agosto de 2013 Cita: Aula 3 Pab I 19 hs |

Resumen: | |

|

Título: A quienes les gustó esta charla también les gustó ...

Cómo los Sistemas de Recomendación revolucionaron la industria del comercio electrónico. (bajar pdf) Disertante: Ernesto M. Mislej Fecha: Jueves 27 de Junio de 2013 Cita: Aula 3 Pab I 19 hs |

Resumen: | |

|

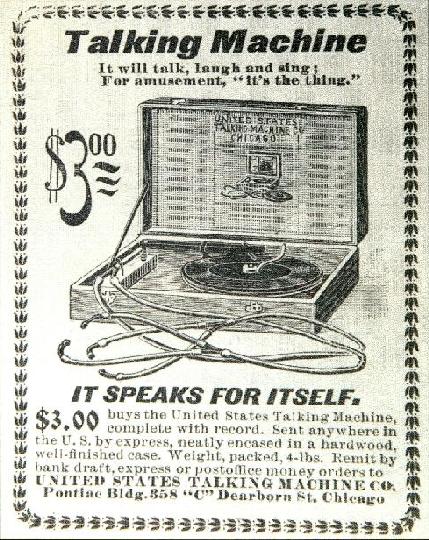

Título: ¿Me escuchás bien? ¡Fuerte y claro!

Cómo lograr que las computadoras hablen mejor. (bajar pdf) Disertante: Christian G. Cossio Mercado Fecha: Jueves 6 de Junio de 2013 Cita: Aula 3 Pab I 19 hs |

Resumen: | |

|

Título: Sube a mi voiture y conéctate a mi red! (bajar pdf)

Disertante: Lautaro Dolberg Fecha: Viernes 23 de Noviembre de 2012 Cita: Aula 8 Pab I 16 hs |

Resumen: | |

|

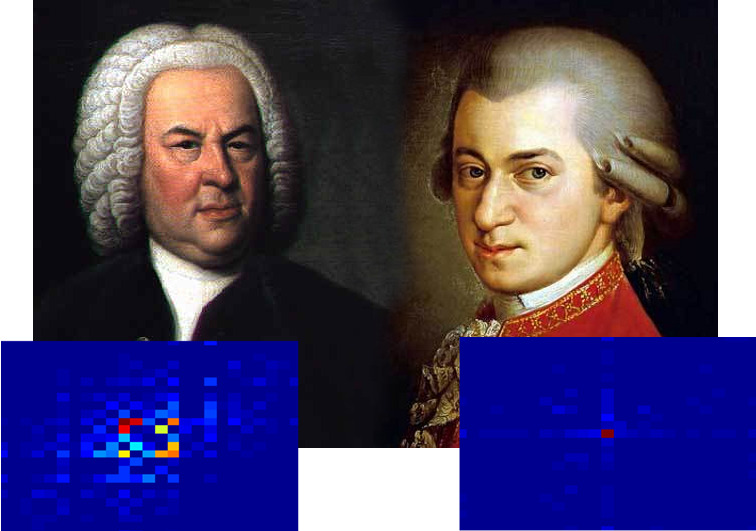

Título: ¿Cuán dificil es distinguir a Bach de Mozart? (bajar pdf)

Disertante: Pablo Rodriguez Zivic Fecha: Viernes 9 de Noviembre de 2012 Cita: Aula 8 Pab I 16 hs |

Resumen: | |

|

Título: Llegando al límite de la normalidad (bajar pdf)

Disertante: Pablo Heiber Fecha: Viernes 26 de Octubre de 2012 Cita: Aula 8 Pab I 16 hs |

Resumen: | |

|

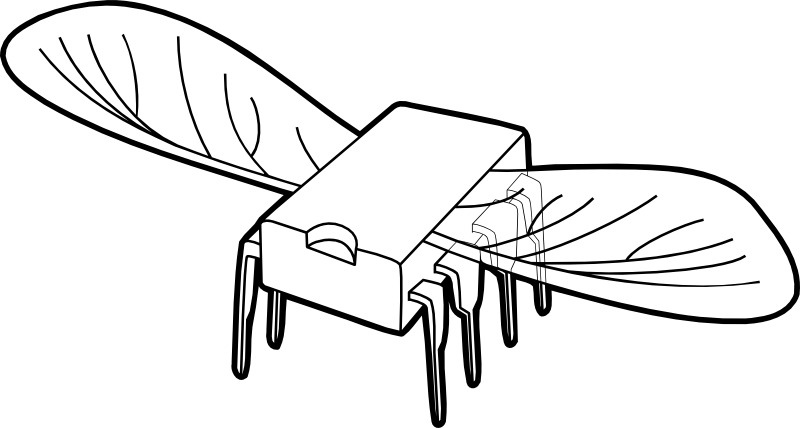

Título: Sistemas embebidos: del Apollo 11 al iPhone 5 (bajar pdf)

Disertante: Sol Pedre Fecha: Viernes 12 de Octubre de 2012 Cita: Aula 8 Pab I 16 hs |

Resumen: | |

|

Título: Sistemas polares: Cómo hacer ciencia en la Antártida (bajar pdf)

Disertante: Sebastián Galimberti Fecha: Viernes 28 de Septiembre de 2012 Cita: Aula 8 Pab I 16 hs |

Resumen: | |

|

Título: Desde la computación hacia el cáncer

Disertante: Nahuel Olaiz Fecha: Viernes 14 de Septiembre de 2012 Cita: Aula 8 Pab I 16 hs |

Resumen: | |

|

Título: Apagá la tele, prendé la compu: análisis automático de video

Disertante: Francisco Gómez Fecha: Viernes 29 de Junio de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

Título: Cuando el perro de Pavlov se robotizó: aprendizaje por refuerzos en psicología, robótica, neurociencias y juegos de Atari (bajar pdf)

Disertante: Carlos "Greg" Diuk Fecha: Viernes 15 de Junio de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

Título: Algo sobre visión en robótica o ¿Cómo diablos ve Wall-e?(bajar pdf)

Disertante: Pablo de Cristóforis Fecha: Viernes 1ro de Junio de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

Título: Ingeniería de software para vagos:

verificando software según la ley del menor esfuerzo (bajar pdf)

Disertante: Esteban Pavese Fecha: Viernes 18 de Mayo de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

Título: Curso acelerado de buenos modales (bajar pdf)

Disertante: Facundo Carreiro Fecha: Viernes 4 de Mayo de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

Título: IMAGENES SATELITALES: ¿qué ves cuando me ves?

Disertante: Daniel Acevedo Fecha: Viernes 20 de Abril de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

Título: Lenguajes formales vs no tan formales ó James Bond vs The dude: ¿Cuál es el mejor look para especificar requerimientos? (bajar pdf)

Disertante: Fernando Asteasuain Fecha: Viernes 30 de Marzo de 2012 Cita: Aula 2 Pab I 16 hs |

Resumen: | |

|

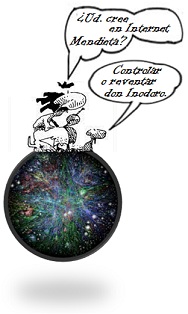

Título: ¿Ud. cree en Internet Mendieta? -Controlar o reventar, don Inodoro. Modelos y simuladores en tiempo real para control de performance en redes de datos (bajar pdf)

Disertante: Lic. Rodrigo Castro Fecha: Viernes 16 de Diciembre de 2011 Cita: Aula 3 Pab I a las 12:30 (puntual) |

Resumen: | |

|

Neuro-robótica: neurociencia, redes neuronales artificiales y robótica humanoide. ¿Ficción o futuro? (bajar pps)

Disertante: Dra. Rosana Matuk Fecha: Viernes 25 de Noviembre de 2011 Cita: Aula 3 Pab I a las 15:30 (puntual) |

Resumen: | |

|

¿De qué hablamos cuando hablamos de información?

Disertante: Lic. Pablo Heiber Fecha: Viernes 11 de Noviembre de 2011 Cita: Aula 3 Pab I a las 15:30 (puntual) |

Resumen: | |

|

Automatización del Gallo Mecánico (bajar pdf)

Disertante: Lic. Beta Ziliani Fecha: Martes 1 de Noviembre de 2011 Cita: Aula 9 Pab I a las 15:30 (puntual) |

Resumen: | |

|

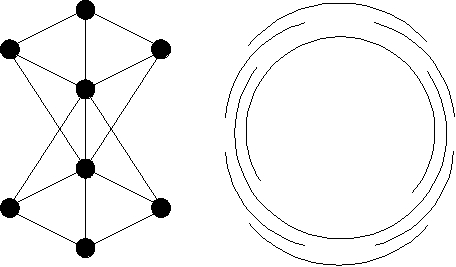

El complejo de los grafos (bajar pdf)

Disertante: Dra. Flavia Bonomo Fecha: Viernes 14 de Octubre de 2011 Cita: Aula 3 Pab I a las 15:30 (puntual) |

Resumen: | |

|

Música, computación y neurociencia, pura dinamita (bajar pdf)

Disertante: Lic. Pablo Hernán Rodriguez Zivic Fecha: Viernes 23 de Septiembre de 2011 Cita: Aula 3 Pab I a las 15:30 (puntual) |

Resumen: | |

|

GridMatrix, Calidad, Servicio y LIR (abrir svg)

Disertante: Lic. David González Márquez Fecha: Viernes 9 de Septiembre de 2011 Cita: Aula 3 Pab I a las 15:30 (puntual) |

Resumen: | |

|

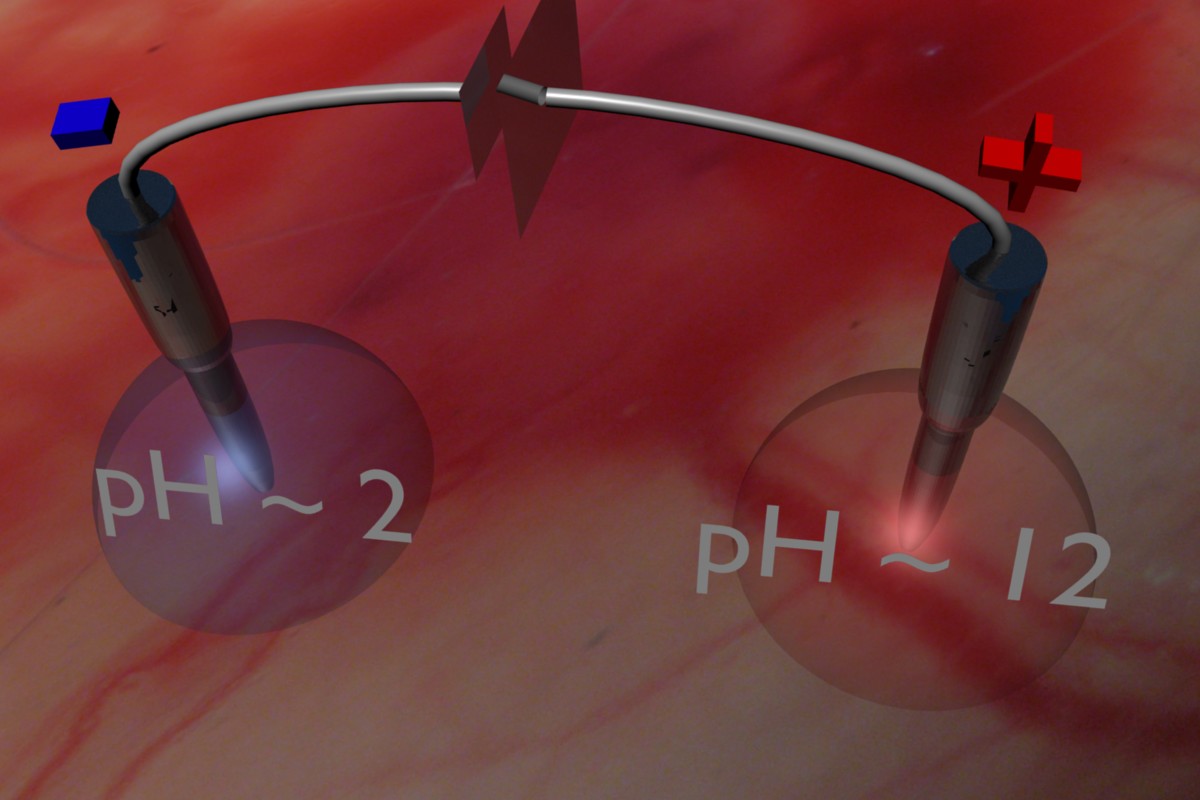

AC/DC en vivo (bajar pdf)

Disertante: Dr. Pablo Turjanski Fecha: Viernes 8 de Julio de 2011 Cita: Aula 8 Pab I a las 15:30 (puntual) |

Resumen: | |

|

El secreto de tus ojos

Disertante: Lic. Marcelo Mottalli Fecha: Viernes 10 de Junio de 2011 Cita: Aula 8 Pab I a las 15:30 (puntual) |

Resumen: | |

|

Como censar 5.581.761 viviendas en un día y no morir en el intento

Disertante: Lic. Diego Delle Donne Fecha: Viernes 20 de Mayo de 2011 Cita: Aula 8 a las 15:30 (puntual) |

Resumen: | |

|

2011 - Odisea en el Ciberespacio (bajar pdf)

Disertante: Dr. Diego Fernández Slezak Fecha: Viernes 6 de Mayo de 2011 Cita: Aula 8 a las 15:30 (puntual) |

Resumen: | |

|

Con ustedes... el fabuloso hombre TACO

Disertante: Dr. Juan Pablo Galeotti Fecha: Viernes 8 de abril de 2011 Cita: Aula 2 a las 15:35 (puntual) |

Resumen: | |

|

Una imagen vale más que mil fórmulas

Disertante: Lic. Guido de Caso Fecha: Viernes 10 de diciembre de 2010 Cita: Aula 2 a las 15:35 (puntual) |

Resumen: | |

|

¿Por qué no habla mi computadora (todavía)?

Disertante: Lic. Agustín Gravano Fecha: Viernes 3 de diciembre de 2010 Cita: Aula 2 a las 14:45 (puntual) |

Resumen: | |

|

Modelos, juegos y... Síntesis de controladores!

Disertante: Nicolas D'Ippolito Fecha: Viernes 19 de noviembre de 2010 Cita: Aula 4 (Pab. 1) a las 15:30 (puntual) |

Resumen: | |

|

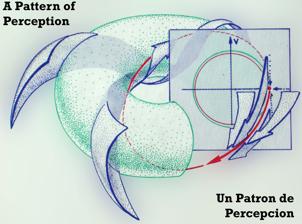

Un patrón de percepción. Disertante: Andrés Valloud Fecha: Jueves 24 de mayo de 2007 Cita: Aula 10 (Pab. 1) a las 15:30 (puntual) |

Resumen: | |

|

Álgebra Conmutativa y Geometría Algebraica Computacionales: un estudio en la frontera de mis conocimientos. Disertante: Lic. Enrique Tobis Fecha: Viernes 30 de marzo de 2007 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: En esta charla presentaré algunos temas de Geometría Algebraica que no se suelen tratar en la Lic. en Computación, enfatizando sus aspectos algorítmicos. Más precisamente, hablaré de algunas formas de trabajar con polinomios en una computadora. Si logro mantenerlos despiertos, también contaré aplicaciones del Álgebra Conmutativa a la Combinatoria (grafos) que estoy estudiando en este momento. | |

|

Esos locos grafitos Disertante: Lic. Francisco Soulignac Fecha: Viernes 24 de noviembre de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: | |

|

Hurgando el cerebro con autitos Disertante: Lic. Demián Wassermann Fecha: Viernes 27 de octubre de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: Podemos hacer que la computadora vea dentro del cerebro? Y que pasa si transformamos al cerebro en una pista de autitos a control remoto? Lo qué!? Una pista de autos en el cerebro? Y eso para sirve? En esta charla vamos a introducir el procesamiento de imágenes en 3D. Vamos a mostrar como se aplica para poder procesar imágenes de resonancia magnética cerebral y después vamos a ver como mediante autitos a control remoto podemos extraer información del cerebro | |

|

Modelos de Programación Lineal Entera Disertante: Dra. Paula Zabala Fecha: Viernes 13 de octubre de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: Muchos de estos problemas pueden ser modelados mediante formulaciones de programación lineal entera o entera mixta. En los últimos años, los métodos Branch-and-Cut resultaron ser una de las técnicas más efectivas para resolver un modelo de programación lineal entera. Especialmente las implementaciones basadas en combinatoria poliedral han permitido incrementar el tamaño de las instancias resueltas. Este tipo de algoritmo ha sido aplicado exitosamente en la resolución de grandes instancias del problema del viajante de comercio, distintos problemas de ruteo de vehículos, problemas de diseño de redes, de planificación de la producción, problemas provenientes del área de telecomunicaciones y problemas en grafos, entre otros. También es la herramienta que ha sido implementada en los paquetes comerciales para resolver este tipo de problemas. En esta charla describiremos esta eficiente técnica y discutiremos los factores a tener en cuenta en el desarrollo de un algoritmo de este tipo para un problema específico. | |

|

Había una vez una facultad... Disertante: Lic. Pablo Factorovich Fecha: Viernes 22 de septiembre de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen:

| |

|

¿Por qué no habla mi computadora (todavía)? Disertante: Lic. Agustín Gravano Fecha: Viernes 25 de agosto de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: | |

|

Teoría y algoritmos de cake-cutting Disertante: Dr. Tomás Tetzlaff Fecha: Viernes 11 de agosto de 2006 Cita: Aula 3 a las 18:30 (puntual) |

Resumen: | |

|

De Euclides a la telefonía celular. Disertante: Dr. Javier Marenco Fecha: Viernes 7 de julio de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: Todos estos problemas forman parte de los temas que estudia la optimización combinatoria. Como en muchos otros casos, no se conocen algoritmos eficientes para resolverlos y, peor aún, se sospecha que en realidad no existen algoritmos con estas características. Sin embargo, este tipo de problemas surge cotidianamente en la operatoria de empresas y organizaciones, con lo cual es muy importante contar con métodos computacionales eficientes para resolverlos. Ahora bien, ¿cómo se hace para resolver en forma computacionalmente eficiente un problema para el cual no se conocen algoritmos eficientes? En esta charla veremos cómo se puede lograr este hecho aparentemente imposible, combinando técnicas basadas en programación lineal con el estudio de ciertos poliedros asociados a modelos combinatorios. | |

|

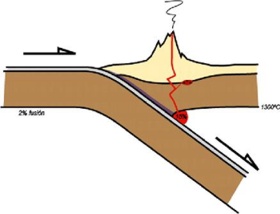

Montañas calientes: Modelos, mecánica y mucha temperatura Disertantes: Lic. Javier Quinteros Fecha: Viernes 23 de junio de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: ¿Dónde van a haber terremotos? ¿Qué pinta tenían los Andes hace 20 Millones de años? La geología como disciplina atravesó un gran cambio paradigmático en los últimos 35 años. Esto llevó a hacer una revisión profunda de las teorías válidas hasta aquel momento, que pretendían explicar la formación de cordilleras, cuencas, el fondo oceánico, etc. Obviamente, a partir de ese momento, las herramientas numéricas han sido un gran apoyo para el estudio de la Tectónica de Placas. En la charla, vamos a repasar un poco lo que se sabe hasta hoy, en qué se está trabajando en los principales centros de investigación del mundo y plantearemos algunas preguntas que están sin responder (aunque por muy poco tiempo). También comentaremos por qué los egresados de nuestra disciplina pueden llegar a avanzar mucho más en geología que los propios geólogos, y algunos... llenándose de plata. Veremos cómo con un poco de ingeniería, matemática, física, paralelismo en clusters, conceptos de geología y dos puñados de sal se puede llegar a la frontera del conocimiento. | |

|

Alloy en su tinta... Disertantes: Lic. Juan Pablo Galeotti y Lic. Mariano Moscato Fecha: Viernes 02 de junio de 2006 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: Veremos como el uso de esta herramienta nos lleva a campos como la generación automática de casos de tests, y la verificación tanto de especificaciones, como código java "anotado" con invariantes, pre y post condiciones. | |

|

De cómo nos engañaron en Algebra I o cómo hacer para resolver sistemas lineales en serio (tengo un algoritmo en papel, 2 procesadores y un problema lineal enorme, ¿¡¿qué hago?!?) Disertantes: Dr. Hugo Scolnik (DC, FCEN) e Ing. Miguel Angel Cavaliere (SIDERCA) Fecha: Viernes 19 de mayo de 2006 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: | |

|

De Leibniz a Omega Disertante: Dr. Gregory Chaitin (IBM Research Center) Fecha: Lunes 08 de mayo de 2006 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

|

Somos mucho más que dos... Disertante: Lic. Marina Groshaus Fecha: Viernes 21 de Abril de 2006 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

|

Las especificaciones formales existen. Disertante: Lic. Nicolás Kicillof Fecha: Viernes 25 de Noviembre de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: Este fenómeno se observa, por ejemplo, en el creciente uso industrial de lenguajes formales de especificación, especialmente en el marco del diseño por contratos. Ejemplos de estas notaciones son Eiffel, JML, Object Constraint Language (en UML) y Spec#, así como la inclusión de assertions (afirmaciones) en el código fuente. Los modelos formales de sistemas reactivos también se han extendido del ámbito del software crítico a las tareas de aseguramiento de calidad para aplicaciones de uso masivo. Esta es una oportunidad inigualable para que estudiantes y egresados de nuestra carrera puedan aplicar en su actividad privada valiosos conocimientos curriculares que, si bien les servían como base implícita para producir mejores programas, eran generalmente desdeñados por sus superiores. Aunque este proceso de adopción es un éxito para la comunidad científica; también nos presenta el desafío de adecuar nuestros métodos y herramientas, muchas veces limitados a casos teóricos y simplistas, a las necesidades del "mundo real". Y además nos exige considerar las notaciones y prácticas que ha adoptado la industria, ya que adaptan al uso del practicante general las teorías que venimos proponiendo. En esta charla muestro algunas herramientas basadas en especificaciones formales que se usan hoy en día para mejorar la calidad de software comercial. |

|

|

Pegame y llamame Marta...(o en otras palabras, el estudio de la respuesta inflamatoria en seres humanos) (bajar pdf) Disertante: Dra. Rocío Romero Zaliz Fecha: Viernes 11 de Noviembre de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

|

Hay contornos....y Contornos Disertante: Lic. Juliana Gambini Fecha: Viernes 28 de Octubre de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: Los métodos clásicos para resolver estos problemas como los filtros o máscaras, han sido muy estudiados y desarrollados pero producen resultados poco satisfactorios cuando se desea obtener estructuras geométricas bien definidas. Los contornos activos constituyen una |

|

|

Título:¿Sueñan los robots con daikiris eléctricos? Disertante: Lic. Diego Bendersky Fecha: Viernes 30 de Septiembre de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: En esta charla exploraremos, a partir de una definición de robot autónomo, algunas de las técnicas más utilizadas de control de robots. Explicaremos de qué manera la inteligencia artificial y la biología han influido en el desarrollo de robots y veremos también cómo es posible hacer que los robots aprendan nuevos comportamientos por su cuenta. En particular, nos centraremos en una técnica de aprendizaje denominada Aprendizaje por Refuerzo, en la cual un robot aprende por medio de la interacción con el entorno. Mostraremos los éxitos de esta técnica, así como también sus limitaciones y problemas más importantes, y presentaremos uno de los trabajos sobre este tema que estamos llevando a cabo en nuestro laboratorio. |

|

|

Título: Programación Orientada a Aspectos: La verdad desnuda (bajar ppt) Disertante: Lic. Fernando Asteasuain Fecha: Viernes 16 de Septiembre de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: Fue aclamada como una de las 10 tecnologías que cambiarán la forma de vivir en el nuevo siglo, ¿estuvo todo arreglado? ¿Quién está detrás de todo esto? La POA dice tener la posta para encapsular y abstraer correctamente todos los conceptos que forman un sistema, ¿es tan así o se dice más de lo que hay? Todo esto se responderá en la charla. Qué cosas propone la POA, y cómo lo logra. No dejes de perderte esta charla íntima de septiembre donde se desnudarán las verdades de la Programación Orientada a Aspectos. |

|

|

Título: Fotografia 3D - Una dimensión mas allá de la segunda Disertante: Lic. Alejandro Trocolli Fecha: Viernes 2 de Septiembre de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

|

Título: El método infalible para ganar a la ruleta en 21 días. Llame YA! (bajar pdf) Disertante: Lic. Santiago Figueira Fecha: Viernes 19 de Agosto de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: ¿Hay algún problema que no sea computable? Si pensamos en programas que no se cuelgan nunca, ¿es lo mismo programar con "while" que programar con "for"? ¿Cómo se puede extender de manera abstracta el poder de las computadoras? En la primera parte de la charla vamos a responder a estas y otras preguntas. Dentro de la teoría de la computabilidad, el estudio de la aleatoriedad ha despertado mucho interés en los últimos años. En la segunda parte de la charla vamos a hablar sobre esto. ¿Cómo se puede definir la aleatoriedad? Los que aguanten hasta el final de la charla se llevan como premio un método infalible para ganar a la ruleta. |

|

|

To P or not to P, That's the Question (bajar pdf) Disertante: Dr. Carlos Areces Grupo: Investigador de INRIA, Lab. Loria, Francia Fecha: Viernes 5 de Agosto de 2005 Cita: Aula 2 a las 18:00 (puntual) |

Resumen: NOTA: La charla incluye, (por el mismo precio!!), un curso acelerado en nociones basicas de decidibilidad y complejidad, infaltable en la cartera de la dama o el bolsillo del caballero. |

|

|

Vida en un puñado de bits Disertante: Lic. Cristian Rocha Grupo: Bioinformática Fecha: Viernes 22 de julio de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

|

Título: Verificando modelos, o en qué se parecen Pancho Dotto y los diseñadores de software crítico Disertante: Lic. Fernando Schapachnik Grupo: Dependex, Dependable Systems Research Group Fecha: Viernes 8 de julio de 2005 Cita: Aula 2 a las 15:30 (puntual) Bajar presentación de 1,6 MB (pdf zipeado). Bajar versión imprimible de 2 MB (ps zipeado, 4 diapos por hoja). |

Resumen: |

|

|

Antetítulo: Confección del fixture de la Primera División del fúbol chileno mediante Programación Matemática Título: Fútbol, Computación y Matemática juntos, que combinación perfecta! (bajar pdf) Disertante: Dr. Guillermo "Willy" Durán Grupo:Departamento de Ingeniería Industrial de la Universidad de Chile Fecha: Viernes 24 de junio de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: Dr. Guillermo Durán (con licencia en el Departamento de Computacion de la FCEyN) |

|

|

Título: Veo, veo, ¿qué ves? (bajar pdf) Disertante: Lic. Demián Wassermann Grupo: Grupo de procesamiento de imágenes Fecha: Viernes 10 de junio de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

Título: Escenarios: El ingeniero se maquilla y empieza a actuar (bajar pdf) Disertante: Dr. Sebastian Uchitel Filiación:Imperial College - UK Fecha: Viernes 27 de mayo de 2005 Cita: Aula 2 (Pab. 1) a las 15:30 |

|

Resumen: |

|

|

Título: ¿Qué estará pensando la sanguijuela en este momento? (bajar pdf) Disertante: Lic. Sergio Daicz Fecha: Viernes 13 de mayo de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: |

|

|

Título: Los programas al divan! Programas que analizan programas? (bajar pps) Disertante: Lic. Diego Garbervetsky Fecha: Viernes 29 de abril de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: Ejemplos conocidos de herramientas que hacen análisis de programas son: compiladores, optimizadores, intérpretes, ofuscadores de código, refactoreadores, verificadores, generadores de especificaciones!, y muchas más. En la charla vamos a introducir brevemente esta temática, mostrando algunos ejemplos concretos de su utilidad. Luego presentaremos algunas de las técnicas que estamos elaborando en nuestro grupo. En particular: Análisis del comportamiento y el consumo de memoria en programas Java y generacion automática de invariantes (aserciones sobre los posibles valores que pueden tener las variables en distintos puntos del programa). |

|

|

Título: Guarda que chocan las placas tectónicas! De dónde salió el tsunami? Disertante: Lic. Ing. Sergio Zlotnik Fecha: Viernes 15 de abril de 2005 Cita: Aula 2 a las 15:30 (puntual) |

Resumen: Los continentes se mueven y bastante. Asi que tarde o temprano chocan, y ahi se Qué pasa cuando chocan? A los geofísicos y a los petroleros, por diferentes motivos, les interesa estudiar que sucede cuando se produce una colisión entre las placas. En esta charla habaremos de un método de estudio de este fenómeno, aplicado a un tipo particuar de colisión. Hablaremos un poco de métodos númericos (X-FEM, level sets), un poco de física (mecánica de fluidos simplificada, eq térmica) y un poco de geologia y geofísica (subducción, slab detachment). |

|

|

Título: "Apendizaje por refuerzos: ciencias cognitivas, ratas y perros-robot curiosos" Disertante: Lic. Carlos "Greg" Diuk Fecha: Jueves 31 de marzo de 2005 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: El "aprendizaje por refuerzos" asume que la forma en que aprendemos a manejarnos en el mundo es intentando siempre maximizar el beneficio que obtenemos del entorno en que nos movemos. Un "agente" (o sea, una persona, una rata, un robot o un programa), se enfrenta a un ambiente determinado armado de un conjunto de acciones que puede realizar. Ante cada acción el agente podrá determinar, con cierto grado de exactitud, en qué nueva situación se encuentra y cuál fue el beneficio obtenido a través de la acción realizada. El aprendizaje consiste en determinar una "política" (o sea, la mejor respuesta ante cada situación) que lleve a maximizar el beneficio total obtenido. Situaciones de aprendizaje que responden a este esquema pueden modelarse formalmente como Procesos de Decisión de Markov, y existen algoritmos que permiten encontrar una política óptima (o casi) en tiempo polinomial (aunque a veces ese "tiempo polinomial" resulta ser demasiado grande para muchos problemas de la vida real!). En esta charla vamos a presentar brevemente de qué se trata el aprendizaje por refuerzos y plantear algunos de sus problemas. Tomaremos como inspiración resultados observados por psicólogos y economistas (y gente por |

|

|

Título: "Pintar mapas, organizar fiestas... en el fondo, es sólo teoría de grafos" (bajar pdf) Disertante: Lic. Flavia Bonomo Grupo: Teoría de Grafos Dirección: Min Chih Lin y Willy Duran Fecha: Viernes 26 de Noviembre de 2004 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: La Teoría de Grafos tiene muchas aplicaciones en problemas de computación, biología, física, urbanismo, y algunas otras en problemas más cotidianos de la vida real. El grupo de Teoría de Grafos forma parte del grupo de Investigación Operativa y Optimización Combinatoria y trabajamos tratando de encontrar propiedades teóricas de ciertas clases de grafos que, por ejemplo, permitan resolver eficientemente en esas clases de grafos problemas que son difíciles para grafos en general. Uno de esos problemas es el problema de coloreo, conocido en su versión para grafos planares como "el problema de pintar mapas", quien saltó a la fama al obtener el Oscar al mejor actor principal en "El Teorema de los 4 colores", y se consagró hace un par de años con "El Teorema Fuerte de los Grafos Perfectos". El objetivo de esta charla es dar un panorama general de los temas que estamos investigando y sus aplicaciones a problemas reales. |

|

|

Título: "Una mirada computacional a la lógica. O de cómo ganar chicas hablando de lógica" (bajar pdf) Disertante: Lic. Daniel Gorin y Lic. Sergio Mera Grupo: Grupo de Investigación en Lógica y Computabilidad (GLyC) Fecha: Viernes 12 de Noviembre de 2004 Cita: Aula 3 a las 15:30 (puntual) |

Resumen: Desde su nacimiento, la Computación ha estado intimamente ligada a la Lógica. Hoy en día, el interés por la Lógica es impulsado en mucha mayor medida desde la Computación que desde otras disciplinas historicamente afines, como la Matemática o la Filosofía. Actualmente la Computación abarca un número muy diverso de áreas de interés, y en cada una de ellas ciertas lógicas se adecuan mejor que otras. Los criterios a la hora de elegir una lógica son principalmente: un lenguaje acorde al dominio de uso, poder expresivo suficientemente alto y, en la medida de lo posible, un bajo costo computacional. Algunos de los intereses principales de GLyC (Grupo de Investigación en Lógica y Computabilidad) son el estudio de propiedades de lógicas de buen comportamiento computacional (en especial lógicas modales) y el desarrollo de herramientas de demostración automática para las mismas. El objetivo de esta charla es presentar nociones intuitivas sobre cada uno de los temas mencionados en este abstract, que permitan a partir de una re-lectura posterior, la eventual comprensión del mismo. Rating: PG-13. PARENTS STRONGLY CAUTIONED - Some material may be inappropriate for children under 13. |

|

|

Título: "Métodos formales en la ingeniería de software: en busca de la bala de plata" (bajar pdf) Disertante: Lic. Carlos Lopez Pombo Grupo: Métodos formales relacionales Dirección: Dr. Marcelo Frías Fecha: Viernes 29 de Octubre de 2004 Cita: Aula 10 a las 15:30 (puntual) |

Resumen: Como bien nos avisó Frederik Brook en su famoso trabajo "No silver bullet", no hay técnicas mágicas que nos permitan llegar a un destino feliz con nuestros proyectos de software; la analogía proviene de pensar a las eventuales fallas como lobizones y a las técnicas de ingeniería de software como herramientas para acabar con éstos. Ahora bien, qué pasaría si lo que se da en llamar métodos formales fuera una bala de alpaca, qué ocurriría si pudiésemos, con su ayuda, garantizar que muchos (digamos algunos) de los errores de diseño de software que se cometen más comunmente fueran eliminados durante el proceso de desarrollo de forma de que estos nunca impacten en el producto final. La respuesta es que seríamos felices, en particular, tan felices como pérdidas (en vidas, dinero o cualquier otra cosa) hayamos evitado. |

|

|

Título: "Cancer y Computación, estudio en la frontera del conocimiento" Disertante: Diego Fernández Slezak Grupo: Laboratorio de Sistemas Complejos Dirección: Dr. Guillermo Marshall Fecha: Viernes 15 de Octubre de 2004 |

Resumen: Computación: Conjunto de conocimientos científicos y técnicas que hacen posible el tratamiento automático de la información por medio de ordenadores. ¿En qué se relacionan estos conceptos? Los científicos incorporan, cada vez más, las simulaciones numéricas como medio para producir conocimiento. Estas simulaciones son programas de computación que permiten generar realidades virtuales en las que recrean objetos específicos de estudio, como puede ser una galaxia, un río o tejido humano. En esta charla presentaremos algunas simulaciones de tratamientos contra el cáncer que se llevan a cabo en el Laboratorio de Sistemas Complejos del Departamento de Computación. En particular mostraremos algunos experimentos con ratones realizados en convenio con el Instituto de Oncología "Angel H. Roffo" y primeros resultados de simulaciones numéricas del tratamiento electroquímico de tumores. |

|